Así protegemos entornos críticos con modelos que piensan y razonan como un analista de seguridad

En este artículo te contamos cómo aplicamos técnicas avanzadas de inteligencia artificial para mejorar la detección de amenazas en infraestructuras industriales.

En el proyecto SecBluRed, Laude Canarias trabaja en la fase de experimentación para la tarea 2.4, centrada en mejorar la detección de amenazas en los entornos IIoT (Industrial Internet of Things), donde miles de dispositivos conectados generan tráfico de red de forma continua, la ciberseguridad debe ir mucho más allá de las reglas estáticas o el análisis tradicional. Detectar comportamientos anómalos con rapidez y precisión, sin inundar al equipo de seguridad con alertas irrelevantes, se ha convertido en un desafío clave.

En este artículo te contamos cómo aplicamos técnicas avanzadas de inteligencia artificial para mejorar la detección de amenazas en infraestructuras industriales. Lo hacemos con modelos que no solo identifican patrones sospechosos, sino que también explican por qué lo consideran una amenaza.

El exceso de alertas: cuando detectar no es suficiente

Muchos sistemas de detección tradicionales generan un volumen excesivo de alertas, desviando el foco del equipo de seguridad de las amenazas realmente críticas. El resultado: brechas de seguridad que podrían haberse evitado con una correcta priorización de alertas.

Este problema se acentúa en entornos IIoT, donde la infraestructura es crítica, los recursos técnicos son limitados y los sistemas están en constante cambio. En estos escenarios no basta con detectar lo que “parece raro”: es necesario entender qué representa realmente un riesgo.

Aprendiendo lo que es «normal» con autoencoders

Nuestro sistema comienza utilizando un modelo basado en autoencoders, una arquitectura de red neuronal que aprende cómo es el tráfico normal en la red. No necesita reglas ni etiquetas: simplemente aprende a reconstruir el comportamiento habitual cuando todo funciona correctamente.

Cuando el modelo se encuentra con un flujo de datos que no consigue reconstruir bien, lo considera anómalo. Esta técnica resulta ideal para entornos industriales porque:

- No requiere datos etiquetados, que suelen ser escasos en este tipo de entornos.

- Se adapta fácilmente a cambios, reentrenándose con nuevos datos cuando el sistema evoluciona.

- Reduce los falsos positivos y negativos, al aprender qué es “normal” en cada contexto específico.

¿Cómo lo hace exactamente?

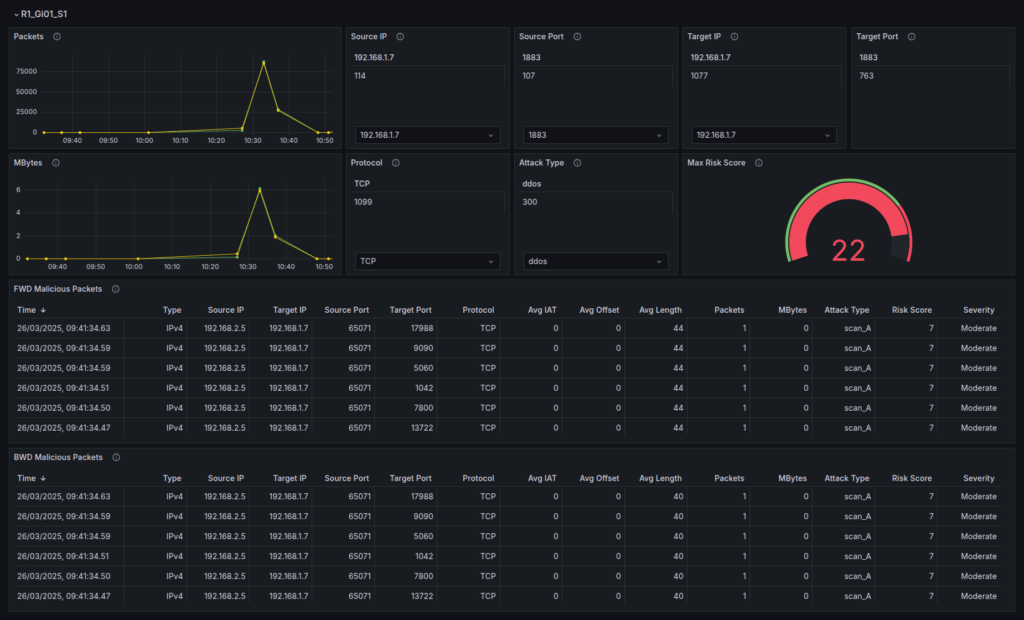

Para identificar estos patrones, el sistema analiza el intercambio de datos entre dos dispositivos, observando la comunicación completa que ocurre en ambos sentidos.

A partir de ahí, la IA se fija en aspectos como:

- Con qué frecuencia se envían los mensajes.

- El tamaño y el volumen total de datos transmitidos.

- El ritmo de las comunicaciones (tiempo que pasa entre un mensaje y otro).

- El uso de ciertos indicadores técnicos de la red que, en algunos casos, pueden señalar escaneos o intentos de intrusión.

Detectar no es suficiente: clasificamos las anomalías

Detectar una anomalía es solo el inicio. El siguiente paso es comprender su naturaleza: ¿Se trata de un escaneo agresivo? ¿Un intento de fuerza bruta? ¿Un ataque DDoS? Para ello, empleamos modelos de machine learning supervisados, entrenados con ejemplos reales de ataques conocidos, que alcanzan precisiones de hasta el 99 % en la clasificación de amenazas frecuentes.

Estos modelos son una base sólida, pero tienen limitaciones: dependen de datos etiquetados y su rendimiento puede verse afectado ante ataques nuevos o poco comunes. Aquí es donde la IA generativa entra en juego como una capa complementaria: aporta explicaciones claras sobre por qué un flujo puede ser sospechoso, y en escenarios desconocidos sugiere hipótesis útiles para ayudar al analista de seguridad a entender qué podría estar sucediendo.

Modelos de lenguaje como Gemini 2.5 Pro, aplicados a esta tarea específica, son capaces de reconocer patrones complejos en el tráfico de red y justificar sus decisiones. Tras múltiples pruebas experimentales, los resultados han sido sorprendentes:

- Un 91 % de precisión cuando se guía al modelo con las clases posibles (prompting supervisado).

- Un 83 % de precisión cuando se deja libertad total en la clasificación (zero-shot prompting).

Esta capacidad de razonamiento aporta un valor añadido esencial: permite a los analistas de seguridad verificar las decisiones de la IA, entender mejor el contexto de la alerta y actuar con mayor confianza.

En Laude Canarias, damos un paso más allá aplicando técnicas de finetuning como LoRA (Low-Rank Adaptation) para adaptar modelos más ligeros, como Gemma 3, y lograr un rendimiento comparable al de modelos más potentes. Esto nos permite ejecutar la solución en infraestructuras con recursos limitados, reduciendo costes operativos y aumentando la seguridad al eliminar la dependencia de servicios en la nube o proveedores externos.

¿Te interesa esta tecnología?

Estamos trabajando para llevar esta solución a producción en distintos entornos. Si quieres saber más, probar o colaborar, contacta con nosotros. En Laude Canarias, creemos que la IA no solo puede proteger: también puede explicar, enseñar y ayudar a tomar mejores decisiones.

Enseñando al modelo con Autoencoders

Este proyecto esta liderado y coordinado por MTP “Métodos y Tecnología de Sistemas y Procesos S.L”. SecBluRed es un proyecto cofinanciado por el Centro para el Desarrollo Tecnológico Industrial (CDTI) a través de la convocatoria Misiones 2022 (resolución 16 de junio de 2022 de la Presidencia del CDTI).